网站抓取频次变低了是怎么回事?--seo资讯

随着互联网的发展,网络爬虫技术被越来越多的网站用于抓取和索引网页信息。然而,有些网站可能会发现自己的抓取频次降低了,这可能会影响到网站的内容被及时抓取和索引,进而影响搜索引擎的排名。那么,网站抓取频次变低了究竟是怎么回事呢?我们又该如何应对?

一、网站抓取频次降低的原因

网站结构问题

如果网站的结构过于复杂,可能会导致网络爬虫在抓取过程中遇到困难。例如,网站使用了大量的 JavaScript、Flash 等技术,可能导致爬虫无法正确抓取和解析网页内容。此外,如果网站的层级过深,也可能会影响爬虫的抓取效率。

网站内容质量问题

网络爬虫对于高质量的内容有较高的抓取频次。如果网站的内容质量较低、重复度较高,可能会导致爬虫对网站的抓取频次降低。

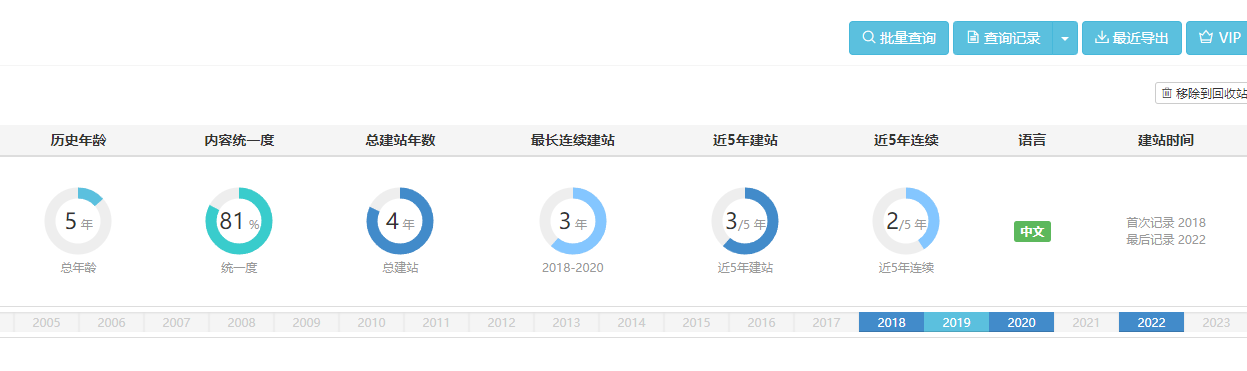

网站更新频率降低

如果网站的更新频率降低,网络爬虫可能会认为网站的价值降低,从而降低抓取频次。

Robots.txt 限制

网站的 Robots.txt 文件可以控制网络爬虫对于网站内容的抓取范围和抓取频次。如果网站的 Robots.txt 文件设置不当,可能会导致爬虫抓取频次降低。

网络爬虫策略调整

网络爬虫会根据网站的情况调整抓取策略,以提高抓取效率。有时候,这种调整可能会导致网站的抓取频次降低。

搜索引擎算法调整

搜索引擎会定期进行算法调整,以提高搜索结果的质量。这些调整可能会影响到网络爬虫的抓取频次。

二、应对网站抓取频次降低的方法

优化网站结构

对于网站结构问题,我们可以通过简化网站结构、减少 JavaScript、Flash 等技术的使用来提高网站的抓取效率。此外,可以使用网站地图、面包屑导航等技术,帮助爬虫更好地抓取和索引网站内容。

提高网站内容质量

对于内容质量问题,我们需要提高网站的原创内容比例,减少重复内容的出现。同时,可以关注用户需求,为用户提供有价值的信息。

保持网站更新频率

为了吸引网络爬虫,我们需要保持网站的更新频率。可以定期发布新内容,或者对现有内容进行修改和优化。

合理设置 Robots.txt

对于 Robots.txt 文件,我们需要合理设置,允许爬虫抓取有价值的内容,同时限制对于无价值内容的抓取。

关注搜索引擎算法动态

搜索引擎算法调整可能会对网络爬虫的抓取频次产生影响。因此,我们需要关注搜索引擎算法的动态,及时调整网站优化策略。

与搜索引擎沟通

如果以上方法都无法解决问题,我们可以尝试与搜索引擎进行沟通,反馈网站的问题。有时候,搜索引擎可能会对网站的抓取频次进行手动调整。

总之,网站抓取频次降低可能是由多种原因造成的,我们需要通过分析具体原因,采取相应的措施来提高网络爬虫的抓取频次。同时,我们需要关注搜索引擎算法的动态,及时调整网站优化策略,以提高网站的抓取效果。